Apple udostępnia modele językowe OpenELM do pracy bez Internetu

Apple wprowadziło nową serię modeli językowych OpenELM zaprojektowanych do pracy lokalnej na urządzeniach bez konieczności łączenia się z usługami w chmurze. Seria obejmuje osiem modeli o różnych rozmiarach i typach, które mają od 270 milionów do 3 miliardów parametrów.

Modele te zostały przeszkolone na ogromnych publicznych zbiorach danych, w tym 1,8 biliona tokenów z zasobów takich jak Reddit, Wikipedia i arXiv.org. Dzięki wysokiemu stopniowi optymalizacji, modele OpenELM są w stanie działać na konwencjonalnych laptopach, a nawet niektórych smartfonach, co zostało zademonstrowane na urządzeniach takich jak komputery PC z procesorami Intel i9 i RTX 4090 oraz MacBook Pro z układem M2 Max.

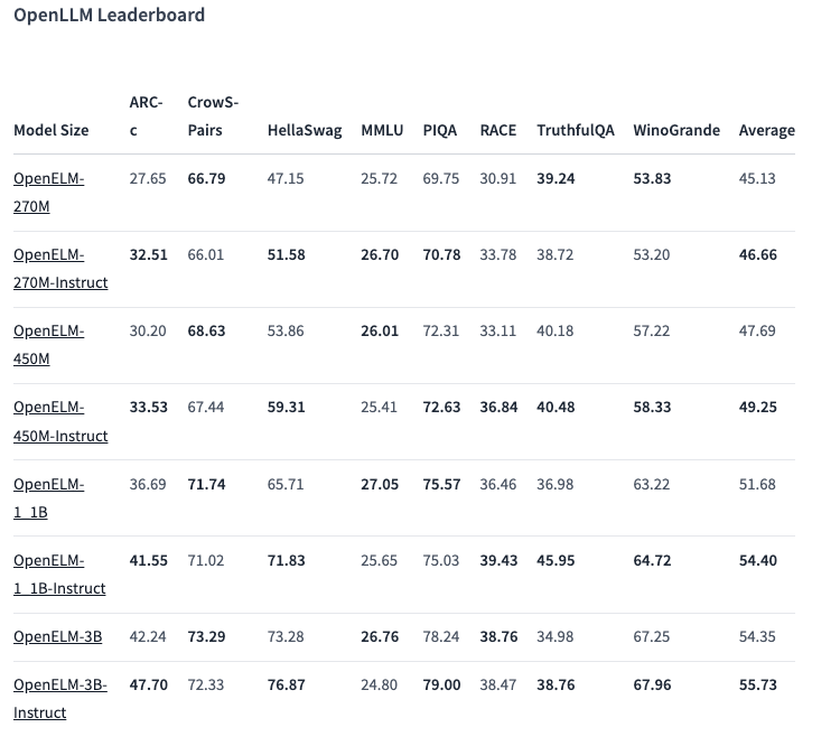

Jedna z wybranych opcji, model z 450 milionami parametrów, z instrukcjami, wykazała doskonałe wyniki. Model OpenELM-1.1B z 1,1 miliardem parametrów okazał się o 2,36% bardziej wydajny niż podobny model GPT, OLMo, przy wykorzystaniu połowy danych treningowych.

W teście porównawczym ARC-C, zaprojektowanym do testowania wiedzy i logicznego rozumowania, wstępnie wytrenowana wersja OpenELM-3B wykazała dokładność na poziomie 42,24%. W innych testach, takich jak MMLU i HellaSwag, model uzyskał odpowiednio 26,76% i 73,28%.

Apple opublikowało również kod źródłowy OpenELM na platformie Hugging Face na otwartej licencji, zapewniając dostęp do wytrenowanych modeli, testów porównawczych i instrukcji pracy z tymi modelami. Firma ostrzega jednak, że modele mogą generować nieprawidłowe, złośliwe lub niedopuszczalne odpowiedzi ze względu na brak gwarancji bezpieczeństwa.