Japonia stworzyła humanoidalnego robota opartego na GPT-4: wynik jest imponujący (wideo)

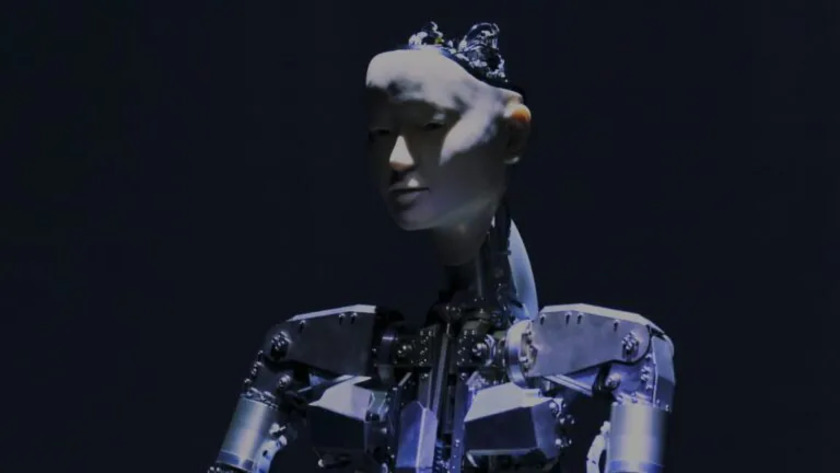

Zespół z Uniwersytetu Tokijskiego zaprezentował Alter3, humanoidalnego robota, który może wykonywać ruchy przy użyciu dużego modelu językowego GPT-4 (LLM).

Alter3 wykorzystuje najnowsze narzędzie Open AI, aby dynamicznie przybierać różne pozy, od selfie po imitację ducha, a wszystko to bez konieczności korzystania z zaprogramowanych wpisów w bazie danych.

“Reakcja Alter3 na wypowiadane treści poprzez mimikę i gesty jest znaczącym postępem w robotyce humanoidalnej, który można łatwo dostosować do innych androidów przy minimalnych modyfikacjach” – twierdzą naukowcy.

W obszarze integracji LLM z robotami nacisk kładziony jest na poprawę podstawowej komunikacji i modelowanie realistycznych reakcji. Naukowcy zagłębiają się również w możliwości LLM, aby umożliwić robotom rozumienie i wykonywanie złożonych instrukcji, zwiększając w ten sposób ich funkcjonalność.

Tradycyjnie, niskopoziomowa kontrola robotów jest związana ze sprzętem i wykracza poza kompetencje korporacji LLM. Stwarza to trudności w bezpośrednim zarządzaniu robotami opartymi na LLM. Rozwiązując ten problem, japoński zespół opracował metodę konwersji ludzkiej ekspresji ruchowej na kod zrozumiały dla Androida. Oznacza to, że robot może niezależnie generować sekwencje działań w czasie bez konieczności indywidualnego programowania każdej części ciała przez programistów.

Podczas interakcji osoba może wydawać Alter3 polecenia, takie jak “Zrób selfie swoim iPhonem”. Następnie robot inicjuje serię zapytań do GPT-4, aby uzyskać instrukcje dotyczące niezbędnych kroków. GPT-4 przetłumaczy to na kod Pythona, który pozwoli robotowi “zrozumieć” i wykonać niezbędne ruchy. Ta innowacja pozwala Alter3 poruszać górną częścią ciała, podczas gdy dolna część ciała pozostaje nieruchoma, przymocowana do podstawy.

Alter3 to trzecia iteracja serii robotów humanoidalnych Alter od 2016 roku, wyposażona w 43 siłowniki odpowiedzialne za mimikę twarzy i ruchy kończyn, wszystkie zasilane sprężonym powietrzem. Taka konfiguracja zapewnia szeroki zakres ekspresyjnych gestów. Robot nie może chodzić, ale może naśladować typowe ruchy chodzenia i biegania.

Alter3 zademonstrował również możliwość kopiowania ludzkich póz za pomocą kamery i frameworka OpenPose. Robot dostosowuje swoje stawy do obserwowanych postaw i zapisuje udane imitacje do wykorzystania w przyszłości. Interakcja z człowiekiem doprowadziła do różnorodności postaw, co potwierdza ideę, że różne ruchy wynikają z naśladowania człowieka, tak jak noworodki uczą się poprzez naśladowanie.

Przed pojawieniem się LLM naukowcy musieli dokładnie kontrolować wszystkie 43 siłowniki, aby odtworzyć ludzką pozę lub naśladować zachowanie, takie jak podawanie herbaty lub gra w szachy. Wymagało to wielu ręcznych ustawień, ale sztuczna inteligencja pomogła uwolnić zespół od tej rutyny.

“Oczekujemy, że Alter3 skutecznie zaangażuje się w dialog, demonstrując kontekstowo istotne mimikę i gesty. Wykazał zdolność do odzwierciedlania emocji, takich jak okazywanie smutku lub szczęścia w odpowiedzi, tym samym dzieląc się z nami emocjami” – twierdzą naukowcy.